|

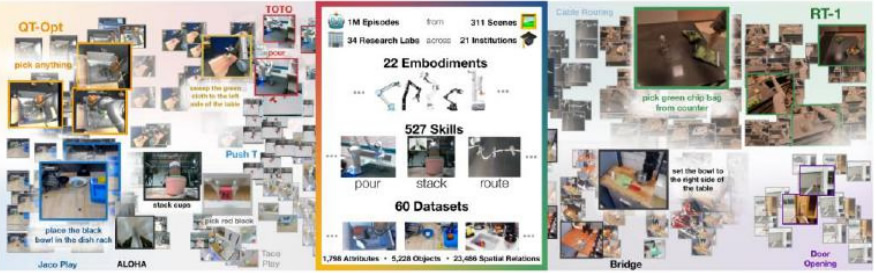

谷歌 DeepMind 在官網發布了大通用大模型之一 RT-X,并開放了訓練數據集

Open X-Embodiment。該數據集來自 21 個研究機構,包含在 22 種類型的機器人上采集的超過 15

萬個任務的上百萬條數據,展示了 527 項技能。諸多人工智能科學家表示,機器人模型的

ImageNet 時刻到來了

采用 Open X-Embodiment 訓練的 RT-X性能表現大幅提升。DeepMind分別基于 RT-1和 RT-2,

采用 Open X-Embodiment 數據集進行訓練得到了 RT-1-X 和 RT-2-X,得益于更多樣化、跨實體

的訓練數據,性能表現較原有模型均有大幅提升。在相同的模型架構下,使用 Open X�Embodiment 數據集訓練的 RT-1-X 平均性能優于原始模型 50%。RT-2-X 則可以執行從未訓練的

操作,涌現能力達到了RT-2的三倍,包括對空間的更好理解,動作的細膩程度等。例如,讓機器

人把蘋果拿到布附近,而不是拿到布上面,RT-2-X 都能很好的區別這些指令的差異,并做出相應

的動作。

DeepMind 的這項新研究表明,通過利用更多樣化的數據和更好的模型進行擴展學習,有可能開

發出更有用的輔助機器人。基于大量機器人數據訓練得到的通用大模型可以在不同環境下應用,

無論是在谷歌 DeepMind 的機器人上,還是在世界各地不同大學的機器人上,其性能都得到了顯著提G。未來的另一個方向是進一步探索不同數據集的混合會如何影響跨具身智能體泛化,以及

這種泛化是如何是實現的。

|