|

2023 年 8 月,Meta 和 CMU 團(tuán)隊(duì)聯(lián)合推出了通用機(jī)器人智能體 RoboAgent。不同于 DeepMind

的 RT 系列模型采用了大規(guī)模機(jī)器人數(shù)據(jù)集進(jìn)行訓(xùn)練,考慮到機(jī)器人在現(xiàn)實(shí)世界中的訓(xùn)練和部署

效率問題,Meta 將數(shù)據(jù)集限制到了 7500 個(gè)操作軌跡中,并基于此讓 RoboAgent 實(shí)現(xiàn)了 12 種不

同的復(fù)雜技能,包括烘焙、拾取物品、上茶、清潔廚房等任務(wù),并能在 100 種未知場景中泛化應(yīng)

用。

構(gòu)建一個(gè)可以泛化到許多不同場景的機(jī)器人智能體需要一個(gè)覆蓋面足夠廣的數(shù)據(jù)集。例如 RT-1

就采用了超過 13 萬條機(jī)器人操作軌跡數(shù)據(jù)來進(jìn)行訓(xùn)練,RoboAgent 則著眼于在有限的數(shù)據(jù)下提

G機(jī)器人學(xué)習(xí)系統(tǒng)的效率,而較少的數(shù)據(jù)通常會(huì)導(dǎo)致模型過擬合。RoboAgent的數(shù)據(jù)集共有7500

條數(shù)據(jù),分別在 4 個(gè)廚房場景中采集,包含 12 個(gè)技能,38 個(gè)任務(wù)。基于此小體量的數(shù)據(jù),Meta

采用了全自動(dòng)的數(shù)據(jù)增廣來對數(shù)據(jù)集進(jìn)行信息擴(kuò)充,通過 Meta 提出的“分割一切模型”

(Segment Anything Model,SAM)來對圖像中的被操作物體和背景進(jìn)行分割,然后分別對被操

作對象和背景進(jìn)行修改,以達(dá)到數(shù)據(jù)集擴(kuò)充的目的。

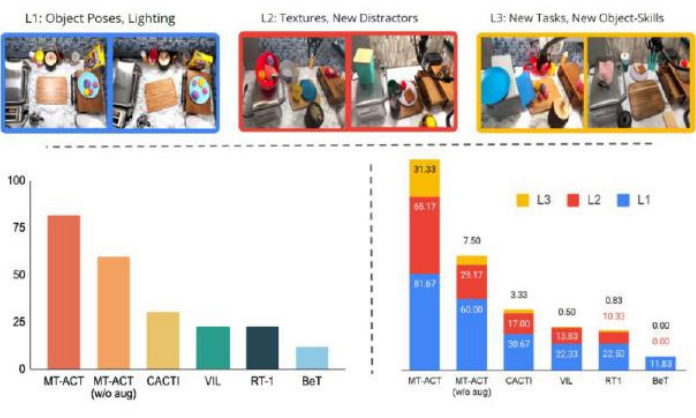

RoboAgent 帶來了數(shù)據(jù)效率的提升。Meta 提出了 MT-ACT——多任務(wù)動(dòng)作分塊 Transformer 這

一學(xué)習(xí)框架,與一些常見的訓(xùn)練算法框架相比,RoboAgent 體現(xiàn)出了更G的樣本效率,并且在多

個(gè)泛化層面上都有出色表現(xiàn)。Meta 對泛化J別進(jìn)行了可視化,L1 表示物體姿態(tài)變化,L2 表示多

樣的桌面背景和干擾因素,L3 表示新穎的技能-物體組合。MT-ACT 的表現(xiàn)顯著優(yōu)于其他算法,

特別是在更困難的泛化層次(L3)上。

|